Le danger du billet du méchant blogueur (anonyme) qui va ruiner votre e-reputation du jour au lendemain c’est un peu aux marchands du temple e-reputation pour leurs clients ce que sont les usines de bombes atomiques de Saddam Hussein pour les médias américains et la communauté internationale : le spectre de la terreur qui permet de faire un jackpot sur les ressources locales.

Et pour cause. Il est difficile de prévoir, de modéliser ce qui va se passer sur Internet. D’ailleurs il est même difficile de surveiller ce qui se dit sur Internet en totalité.

Alors certes on va toujours vous sortir un ou deux cas types qui font vraiment super trop peur. Genre le gamin hargneux qui ouvre un antivol Kryptonite avec un stylo Bic.

Mais soyons honnêtes… Vous en connaissez beaucoup des cas comme ceux la où le dit destructeur d’e-reputation est un anonyme noyé dans la masse du web ? Vous connaissez beaucoup d’entreprises qui ont vu leur situation ruinées par un gamin teigneux de 16 ans qui n’est pas content de son téléphone ou de son antivol?

Le cas Kit Kat VS Greenpeace pour ne citer que lui : si ceux qui ont reçu le courrier d’avertissement de Greenpeace avaient été moins bêtes, si le community manager qui gérait la page Facebook n’avait pas été un stagiaire, on ne serait pas à se gargariser dans les conférences en parlant d’ « issue management » ou d’e-reputation… nous aussi on mangerait nos Kit Kats gentiment !

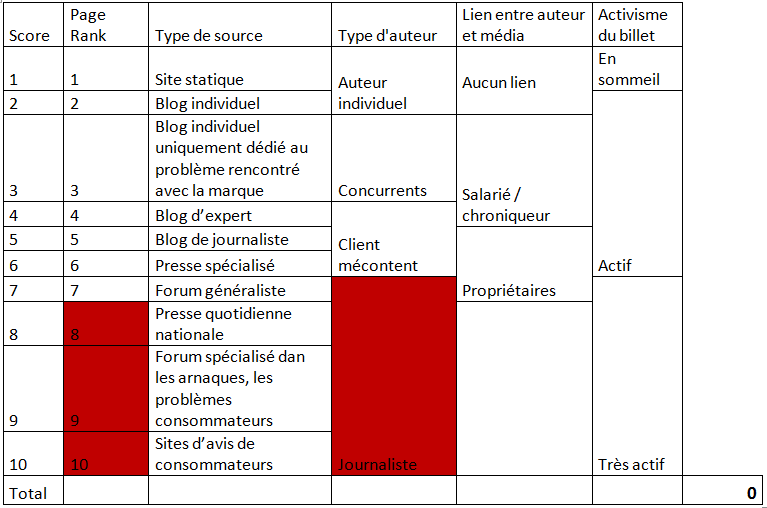

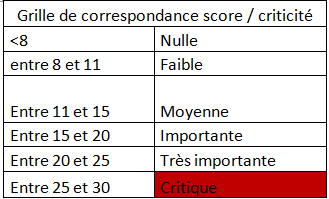

Donc dans le cadre de mes projets j’ai essayé de construire une grille de cotation des risques pour un billet publié sur le Web et mentionnant en mal la dite entreprise.

Je n’ai pas dit que c’était la grille de qualification du siècle, passe partout et magique mais je vous la soumets. Par ailleurs elle est adaptée à mon client qui n’était pas apeuré par le fait de renseigner plusieurs critères car il a une volumétrie d’articles négatifs assez faible. C’est également la version 1 de cette grille et en fonction des premières cotations qui seront effectuées, les seuils seront ajustés.

Elle repose sur plusieurs critères individuels qui permettent d’obtenir une note globale. Et en fonction de la note globale de criticité on peut rentrer dans des procédures de traitement qui sont différentes.

Les critères sont :

On aurait pu multiplier les critères et il y en a d’autres… J’aurais pu également vous dire que si c’est un « expert » qui parle c’est plus dangereux mais j’avais dans le cas présent besoin d’une grille opérationnelle la plus objective possible.

Donc voilà le travail (et je le rappelle c’est un travail qui a été fait spécifiquement pour le projet sur lequel je travaille actuellement.) :

Les cases rouges représentent un seuil de criticité assez élevé pour que la menace soit prise immédiatement au sérieux. En dehors de ces cases rouges, tous les points de chaque critère s’additionnent et le score total détermine le seuil de criticité de la publication selon la grille de correspondance ci-après.

Les seuils de cette grille de correspondance ne sont pas figés, ils sont à adapter en fonction des besoins et en fonction des moyens à disposition de l’entreprise pour gérer sa réputation en ligne.

Voilà, pour ceux que ça intéresse de pouvoir prendre un peu de recul sur les billets publiés et sur leur impact potentiel, peut être que cela vous sera utile. En ce qui me concerne j’évite d’abuser des « bouh qu’il est méchant ce billet… Vous avez pas de chance mon bon Monsieur mais là si vous ne faites rien vous allez mettre la clé sous la porte. » J’essaie toujours de juger le plus froidement possible, de la façon la plus détachée possible ce qui est publié.

Dernier point pour ceux qui voudraient catégoriser d’autres sources en peu en masse pour avoir d’autres critères quantitatifs sur les pages et / ou sites, vous pouvez toujours recourir au petit script qu’a développé Sindup voire même vous servir directement de leur plateforme pour cela.

Publicité